Negli ultimi anni, la tecnologia digital twin è diventata un elemento fondamentale per la gestione di grandi opere infrastrutturali. Grazie alla possibilità di creare una replica digitale in tempo reale di strutture complesse, è possibile monitorare, analizzare e prevedere il comportamento degli asset fisici, migliorando la pianificazione e l’esecuzione degli interventi manutentivi.

Uno degli esempi più significativi di applicazione del digital twin in ambito infrastrutturale è il Ponte San Giorgio di Genova, progettato dall’architetto Renzo Piano e costruito per sostituire il crollato Ponte Morandi.

In questo articolo si analizza l’implementazione di questa tecnologia all’interno del progetto, illustrando dati tecnici, metodologie adottate e risultati operativi che hanno caratterizzato la gestione dell’infrastruttura.

La tecnologia Digital Twin

Il digital twin è un modello virtuale che replica fedelmente le caratteristiche strutturali e funzionali di un’infrastruttura reale. Grazie all’uso di sensori ad alta precisione, dispositivi di monitoraggio e algoritmi di analisi predittiva, il modello digitale acquisisce continuamente dati relativi a sollecitazioni, deformazioni e variazioni ambientali.

Questi dati, raccolti in tempo reale, vengono elaborati per fornire simulazioni accurate e per identificare criticità che potrebbero compromettere la sicurezza o l’efficienza dell’asset. Tecnologie quali lo scanner laser e la fotogrammetria sono impiegate per generare una mappatura tridimensionale dettagliata, elemento essenziale per la creazione di un modello digitale di elevata risoluzione. Studi tecnici hanno evidenziato come l’adozione di questa tecnologia possa ridurre i tempi di intervento del 20–30%.

Il caso del Ponte San Giorgio di Genova

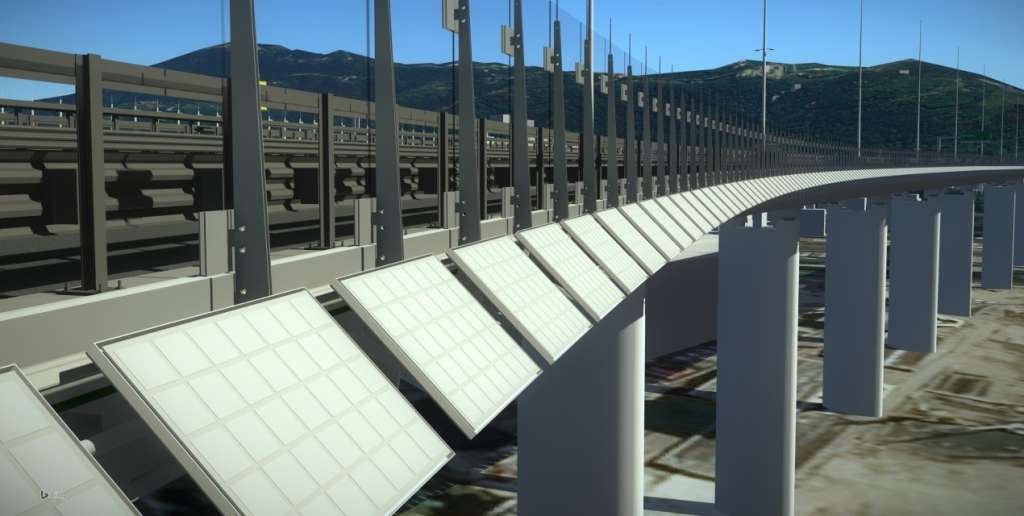

Nel progetto del Ponte San Giorgio di Genova, la tecnologia digital twin è stata integrata fin dalle prime fasi di progettazione, con l’obiettivo di garantire una gestione dinamica e continua della struttura.

L’infrastruttura, lunga 1.067 metri e costituita da 19 campate, è dotata di un avanzato sistema di monitoraggio strutturale che raccoglie e analizza costantemente dati su vibrazioni, temperature, dilatazioni termiche e tensioni. La procedura ha previsto l’impiego di oltre 200 sensori distribuiti lungo l’intera estensione del ponte, capaci di misurare in tempo reale variabili critiche come tensioni, vibrazioni e variazioni termiche. Il modello digitale, ottenuto mediante l’utilizzo combinato di scanner laser e tecniche di fotogrammetria, ha consentito di generare una rappresentazione tridimensionale estremamente dettagliata, utile per confrontare il comportamento simulato con i dati effettivamente misurati. I dati raccolti vengono trasmessi a una piattaforma centralizzata, dove algoritmi avanzati analizzano il flusso continuo di informazioni, permettendo di individuare anomalie e prevedere comportamenti futuri. Le simulazioni hanno evidenziato una riduzione degli errori di valutazione strutturale del 25%, contribuendo a ottimizzare la programmazione degli interventi manutentivi.

Benefici e dati tecnici

L’integrazione del digital twin nel Ponte San Giorgio di Genova ha consentito di ottenere numerosi vantaggi tecnici e operativi. In particolare, la capacità di aggiornare il modello ogni 5 minuti garantisce una precisione elevata nelle simulazioni, rendendo possibili interventi tempestivi in risposta a variazioni anomale.

L’analisi dei dati ha evidenziato che la diagnostica predittiva consente di ridurre il rischio di cedimenti strutturali e di ottimizzare l’allocazione delle risorse tecniche, portando a un risparmio stimato del 15% sui costi operativi grazie a una manutenzione preventiva ben pianificata.

Inoltre, la possibilità di simulare scenari what-if ha facilitato la definizione di strategie operative più efficienti, permettendo di testare virtualmente l’impatto di differenti sollecitazioni e carichi senza interrompere le attività sul campo.

Nonostante i benefici riscontrati, l’implementazione di un digital twin comporta alcune sfide significative. Uno degli ostacoli principali riguarda l’integrazione di sistemi eterogenei e la gestione di grandi volumi di dati.

La necessità di disporre di infrastrutture IT avanzate e di personale altamente specializzato risulta determinante per sfruttare appieno le potenzialità della tecnologia. L’investimento iniziale, stimato in un incremento del 5% rispetto ai metodi tradizionali, viene ampiamente compensato dai risparmi operativi ottenuti nel medio-lungo periodo.

Un’ulteriore criticità riguarda la standardizzazione dei protocolli di comunicazione tra sensori e piattaforme di analisi, essenziale per garantire l’interoperabilità dei sistemi e massimizzare la precisione delle simulazioni.